超透镜与计算成像的结合,为成像系统的轻小型化提供了极具潜力的解决方案。然而,长期以来,受限于传统的点对点成像模型,超透镜单镜片计算成像系统难以同时满足实际应用中对视场、口径与工作波段的综合性能需求。

近日,同济大学精密光学工程研究所王占山、程鑫彬教授团队的顿雄副教授,联合斯坦福大学Gordon Wetzstein教授和中国科学院上海技术物理研究所陈凡胜研究员,提出了一种新的神经阵列成像模型和设计方法。该方法通过小口径超透镜满足视场与波段的成像需求,并利用神经网络优化的透镜阵列排布突破口径限制。研制了一款具备实用化综合性能的单片轻薄彩色视频成像相机(口径2.76mm,视场50°,波段400-700nm,成像帧率25Hz)。该研究为超透镜轻薄成像系统的实用化发展提供了全新的思路,并为未来实现高性能、紧凑型成像设备提供了解决方案。相关研究成果以“Neural Array Meta-Imaging”为题发表在国际顶级光学期刊《光:快讯》(eLight)。

在安防监控、无人机巡检、机器视觉、医学成像和消费电子等领域,对轻小型、高质量成像系统的需求日益迫切。传统光学成像系统采用多个笨重的折射元件构成,综合性能好,但体积重量减少难。超透镜成像系统采用单个平面化的超表面元件构成,系统轻薄,但由于固有色差大,其综合性能(包括口径、视场、波段及成像质量)仍难以与传统多片光学系统相比。

将超透镜与计算成像相结合,可将部分像差校正任务由光学端转移至算法端,有望在保持系统轻薄特性的同时,实现媲美传统光学成像系统的综合性能。然而,迄今尚无研究实现这一目标,根源在于现有的点对点成像模型存在固有限制:孔径、视场、波段与成像质量之间存在不可避免的权衡。当口径或视场增大时,不同波长下的波像差显著上升,使得系统在该模型框架下难以补偿,从而导致调制传递函数(MTF)大幅下降。MTF用于量化成像系统的信息传递能力,尽管后处理算法可在一定程度上弥补,但其效果受系统噪声限制。在理想无噪声条件下,任何非零MTF理论上均可恢复;但在现实系统中,当MTF低于噪声相关阈值时,精确恢复将变得不可靠,导致重建图像质量显著下降。

同济大学、斯坦福大学、中国科学院上海技术物理研究所的联合团队提出了一种神经阵列成像系统,从根本上克服了孔径、视场、波段与成像质量之间的固有权衡。如图1所示,该系统采用新的神经阵列成像模型。传统的大口径超构透镜被分解为多个小口径超构透镜单元的组合,使系统在不同波长下的波像差不再随着口径和视场的增加而急剧上升。以口径2.76 m、视场50°、波段400–700 m的设计参数为例,神经阵列模型将450 nm与650 nm处的波像差从原先超过90个波长有效降低至约1个波长。这一改进在MTF曲线上得到印证:神经阵列模型能使系统的MTF始终保持在噪声阈值之上,从而显著提升算法可恢复性与成像质量。

图1、神经阵列超构透镜成像系统工作原理及效果图。(a)系统由超构透镜阵列、CMOS探测器和计算层芯片组成。(b)神经阵列成像模型与传统点对点成像模型的示意对比。(c)–(d)与(f)–(g)分别比较了在大口径相机中,两种成像模型的波像差与调制传递函数(MTF)分布。(e)与(h)展示了两种成像模型在不同指标下的性能分布图。

该模型设计的关键在于确定小口径透镜的最佳排布方式及数量。简单的周期性排布会导致系统MTF出现多个零频点,而打破周期性则可有效避免这一问题。研究团队通过神经网络驱动的透镜阵列端到端设计方法解决了这一难题,并进一步开发了多尺度特征域维纳反卷积深度融合网络(MFWDFNet),以实现物理可解释、细节保真度高的图像重建。

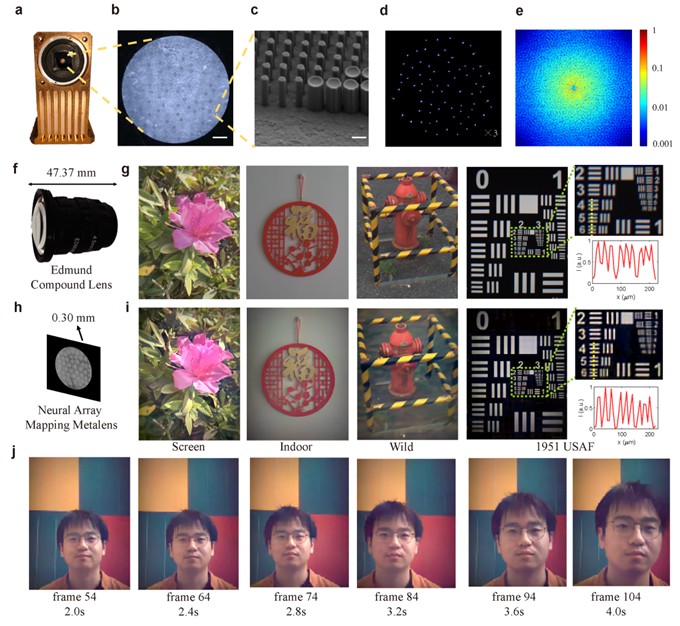

基于神经阵列成像模型与上述端到端设计方法,研究团队研制出一款孔径2.76 mm、F数1.45、视场50°、帧率25 Hz、光谱范围400–700 nm的神经阵列成像系统。如图2所示,该系统在72 lp/mm处的平均MTF与参数相近的商用复合透镜(如Edmund 33-300)相当,并在室内外场景下均展现出优异成像质量。同时,系统总光路长度由57 mm缩短至4.3 mm,实现约13倍的厚度压缩。此外,研究团队还验证了该系统在任务级视觉感知中的适用性(如图3所示),实验结果表明,神经阵列成像系统在深度估计与目标检测任务中表现出与常规相机相近的精度,充分展示了其在智能视觉领域的应用潜力。

图2、神经阵列超构透镜成像系统成像性能测试。(a)原型机;(b)光学显微图;(c)扫描电子显微图;(d)系统的点扩散函数。(e)系统的MTF;(f)Edmund复合透镜。(g)使用Edmund复合透镜相机拍摄显示屏、室内场景、室外场景及分辨率测试图的成像效果。(h)神经阵列超构透镜成像系示意;(i)神经阵列超构透镜成像系统在相同条件下拍摄的图像;(j)实时视频成像过程中捕获的六帧序列及对应时间。

图3、神经阵列超构透镜成像系统深度估计与目标检测任务测试。(a)预训练的DepthAnythingV2模型样机拍摄的图像进行深度估计结果;(b)预训练的YOLOv5s模型对样机拍摄的图像进行目标检测结果。

该研究提出的神经阵列成像模型突破了超透镜单镜片成像系统在孔径、视场、波段与成像质量之间的固有权衡,实现了在单片轻薄结构下同时兼顾口径、视场、波段和成像质量的彩色视频相机。未来,神经阵列成像概念可进一步拓展至任务导向的智能相机设计,与目标识别、深度感知等神经网络模型联合优化,推动新一代超薄化、智能化、全功能光学系统的发展。该技术在移动终端摄像、无人系统导航、增强现实及工业检测等领域具有广阔应用前景。

同济大学物理科学与工程学院顿雄副教授、张健博士,中国科学院上海技术物理研究所陈凡胜研究员为论文共同第一作者,同济大学物理科学与工程学院王占山教授、程鑫彬教授、斯坦福大学Gordon Wetzstein教授为论文通讯作者。对论文具有突出贡献的合作者还包括同济大学物理科学与工程学院张占一博士、王绪泉助理研究员、邢裕杰博士、董思禹助理教授、范泽鄞博士、施宇智教授。

论文链接:https://doi.org/10.1186/s43593-025-00107-8